콜로라도대(UCB) 연구진, 성별범주화 오류 정신적 스트레스 유발 가능성

아마존•마이크로소프트•아이비엠 등, 성별범주 안면인식 테스트 부정확

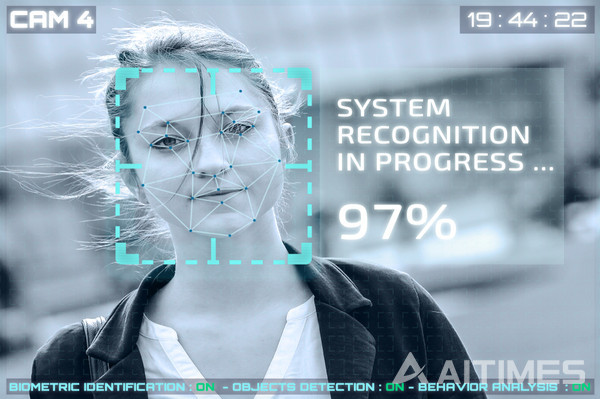

(AI타임스=양태경 기자) 최근 구글(Google) 사태 등 안면인식 기술에 대한 논란이 끊이질 않고 있는 가운데, 콜로라도대학교 볼더 캠퍼스(University of Colorado Boulder, UCB)가 실시한 한 연구가 인공지능(AI)이 ‘비성애자’(non-cisgender)들을 인식하는데 얼마나 미숙한 지를 밝혀냈다고 지난 18일(현지시간) 전해 안면인식 기술에 관심을 가지고 있는 많은 사람들의 큰 관심을 끌고 있다.

‘비성애자’(非性愛者)란, 생물학적 성과 성 정체성이 일치하지 않는 사람으로 신체적 성과 사회적 성이 일치하지 않는 사람들을 말한다.

인종적 소수자를 인식하는 것과 관련 인공지능(AI)이 안고 있는 걱정스러운 문제들이 계속 보고되고 있지만, 이 새로운 연구는 안면인식의 기능에 있어 성별분류를 평가하는 첫번째 연구 중 하나이다.

인공지능(AI) 시스템은, 사람들을 그들이 볼 수 있는 것에 기초해 분류하고 종종 전형적인 매개변수 가령, ‘수컷은 긴 머리가 없고 암컷은 얼굴 털이 없다’를 사용한다.

성별분류를 위한 범주는 우리의 평범한 예상과는 달리 아주 많다. 가령, 페이스북은 사용자들을 위한 약 71개의 성별분류 옵션을 가지고 있을 정도다. 인공지능(AI)이 모든 사람을 정확히 분류할 것이라고 기대하는 것 자체가 지나친 욕심일 수도 있지만, 콜로라도대(UCB) 연구진이 심각한 정신적 스트레스를 일으킬 가능성이 있을 정도로 부정확한 범주화의 오류를 발견했다는 것이다.

이 연구에 참여한 모건 클라우스 셔먼 연구원은 남성으로 분류된다. 하지만 연구에서 진행된 인공지능(AI) 안면인식 실험에서, 마이크로소프트(Microsoft)社의 인공지능(AI)은 그를 남성으로 정확히 식별했지만, 아이비엠 (IBM)社의 인공지능(AI)은 그를 여성으로 식별하는 모순된 범주화 오류를 보였다.

셔먼 연구원은 본격적인 안면인식에 앞서 샘플로 인식 테스트를 했을 때 '시범적' 성별로 남성임을 확인했음에도 불구하고, 막상 자신의 성을 제대로 식별하지 못한 인공지능(AI)이 자신의 성별을 반 시간 동안이나 잘못 분류했다고 말한다.

성별분류가 대략 맞는 한, 당분간은 너무 많은 정신적 스트레스를 주지는 않을 것 같다. 하지만, 그들이 잘못된 성이라고 몇 년 동안 생각하고 과도기 동안 따돌림과 학대에 직면했을 가능성이 있는데다가 아마도 수술이나 호르몬 치료까지 받았는데 그리고 나서야 인공지능(AI)이 그들을 그들이 태어난 원래의 성으로 분류했다고 상상해 본다면 문제는 전혀 달라질 수 있다.

셔먼 연구원과 그의 연구팀은 아마존, 구글, 마이크로소프트, 아이비엠 등을 위시한 인공지능(AI) 안면인식 서비스를 제공하는 10개 社의 성별범주 안면인식 테스트를 진행한 결과, 셔먼 연구원의 성별은 평균적으로 비성애자(非性愛者) 여성으로 그리고 트랜스젠더 남성으로 가장 잘 인식됐다.

패션 트렌드는 시간에 따라 진화한다. 특히, 헤어스타일이 그렇다. 남성들은 어떤 시기 동안 긴 머리를 선택했고, 또 전통적으로 남성처럼 아주 짧게 자른 머리를 하고 성공한 여성 모델들도 있다.

10년쯤 지나면, 남성은 면도를 하고 여성은 수염을 기르는 것이 인기 있을 수도 있다. 현재의 안면인식 알고리즘으로 훈련된 인공지능(AI)은 또 다른 이슈를 포함하고 있는 그러한 변화에 적응해 성별분류를 범주화하기 위해 고군분투할 것이다.

일반적으로 해결책이 없는 문제가 많지만, 해결책이 꼭 필요한 문제도 있다. 성(性)소수자와 같은 공동체들은 이미 사회적 차별이나 불평등과 같은 요인들을 통해 정신건강 악화를 경험할 위험에 더 많이 노출돼 있다. 때문에 미래에 인공지능(AI) 안면인식 자동화에 의한 성별범주 오판이 생사람을 잡을 수도 있는 노릇이어서 각별한 주의가 요구된다.

【에이아이타임스 aitimes 에이아이타임즈】

무단전재 및 재배포 금지

기사제보 및 보도자료 news@aitimes.com