전문 지식보다 인간의 일상 처리 능력 측정

일반인공지능(AGI)을 판단하는 벤치마크가 추가됐다. 인간에게 어려운 작업을 해결하는 능력보다 일상 작업에서 인간과 같은 추론과 능력을 보여줄 수 있는지 평가하는 데 초점을 맞췄다. 그리고 이 테스트에서는 'GPT-4'가 현존 인공지능(AI) 모델 중 최고 점수인 30%를 기록했다.

벤처비트는 27일(현지시간) 메타, 허깅페이스, 오토GPT, 젠AI의 연구진이 추론과 멀티 모달 처리, 웹 브라우징, 도구 사용 등 일련의 기본 능력이 필요한 질문으로 대형언어모델(LLM)을 평가하는 ‘일반인공지능 어시스턴트(GAIA)’ 벤치마크를 발표했다고 보도했다.

이에 따르면 GAIA 벤치마크 테스트 결과 인간은 92%의 점수를 얻었지만, GPT-4는 플러그인 기능을 사용하고도 15%에 불과한 것으로 나타났다. AGI 관점에서 AI가 아직 인간에 크게 못 미친다는 결과다.

연구진은 "GAIA 질문 사항은 개념적으로 인간에게는 간단하지만, 대부분의 AI에는 어려운 문제”라며 “벤치마크가 인간에게 어려운 작업에 초점을 맞추기보다는, AI가 일반 인간과 비슷한 실제적인 능력을 갖추고 있는지 입증해야 한다”라고 주장했다.

현존하는 대부분 LLM은 법이나 과학과 같은 전문 지식이 필요한 작업에서 인간의 능력을 앞지르고 있다. 하지만 GAIA는 수학, 과학, 법률과 같은 전문성보다 일상 업무에서 인간 수준의 상식과 적응성, 추론 능력을 보여줄 수 있는지를 평가하는 데 초점을 맞췄다.

GAIA 벤치마크는 답변이 확실한 466개의 질문으로 구성된다. 그중 300개의 답변은 비공개로 유지하며, 나머지 166개는 질문과 답을 AI를 위한 샘플로 공개한다.

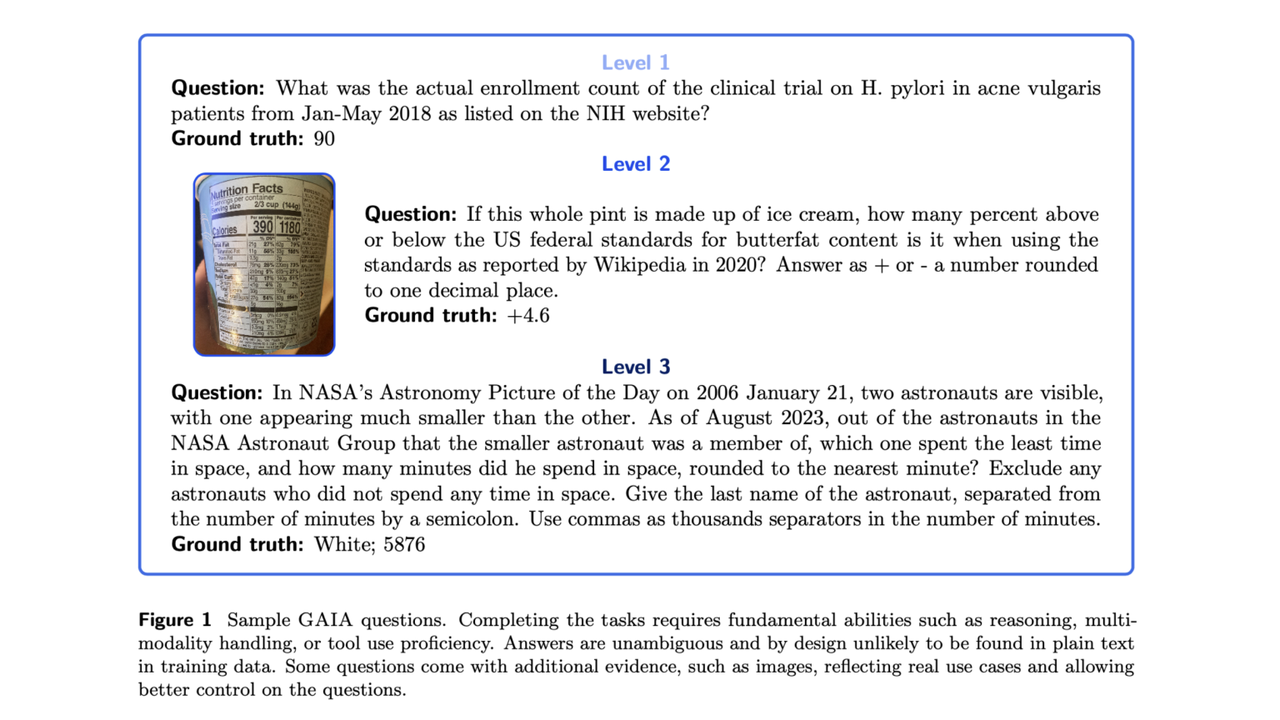

AI 답변의 정확도를 판단하기 위해 GAIA 질문은 세가지 레벨로 분류했다.

우선 ▲레벨 1에 해당하는 질문은 일반적으로 도구가 필요하지 않거나, 최대 하나의 도구가 필요하지만 5단계를 넘지 않는 수준이다. ▲레벨 2 질문은 일반적으로 5~10개의 더 많은 단계를 포함하며 문제 해결을 위해 다양한 도구를 결합해야 한다.

▲레벨 3은 거의 완벽한 인간 수준의 능력이 있어야 하는 수준으로, 긴 작업을 수행하기 위해 다양한 도구를 사용하는 것은 물론 외부로부터 정보를 습득해야 한다.

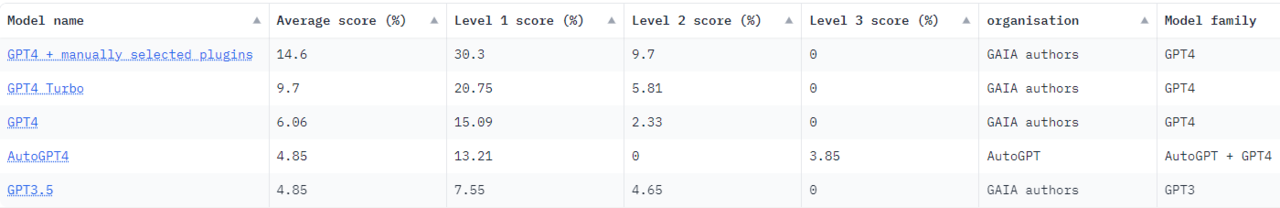

현재까지 최고의 GAIA 정확도를 기록한 것은 GPT-4로, 인간이 수동으로 플러그인을 지정해준 경우다. 레벨 1에서는 30.3%의 정확도를 기록했다. 하지만 레벨 2에서는 9.7%, 레벨 3에서는 0%로 작업이 복잡해지면 급격한 능력 저하를 보였다.

연구진은 “GAIA 질문을 해결하는 대형언어모델(LLM)은 AGI로 인정할 수 있다”라며 “진정한 AGI는 평균적인 인간의 처리 능력과 흡사한 수준을 보여야 한다”라고 말했다.

GAIA 벤치마크는 리더보드도 제공한다. 어떤 LLM이 현재 가장 좋은 성적을 냈는지 확인할 수 있다.

박찬 기자 cpark@aitimes.com

무단전재 및 재배포 금지

기사제보 및 보도자료 news@aitimes.com